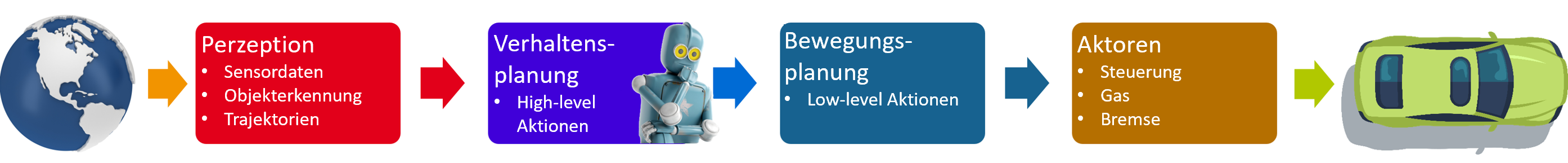

Wir demonstrieren, dass effektive Fahrstrategien in kritischen Situationen durch Simulation gelernt werden können. Hier zeigt sich die Stärke des Reinforcement Learning: Durch Millionen von Fahrstunden im Simulator kann der KI-Agent auch schwierige Fahrsituationen spielend meistern. Wir evaluieren eine breite Menge an stark variierten Szenarios. Das Fahrverhalten wird auf verschiedene Faktoren optimiert, wie etwa die Sicherheit der Insassen durch Berücksichtigung von Kollisionszonen.

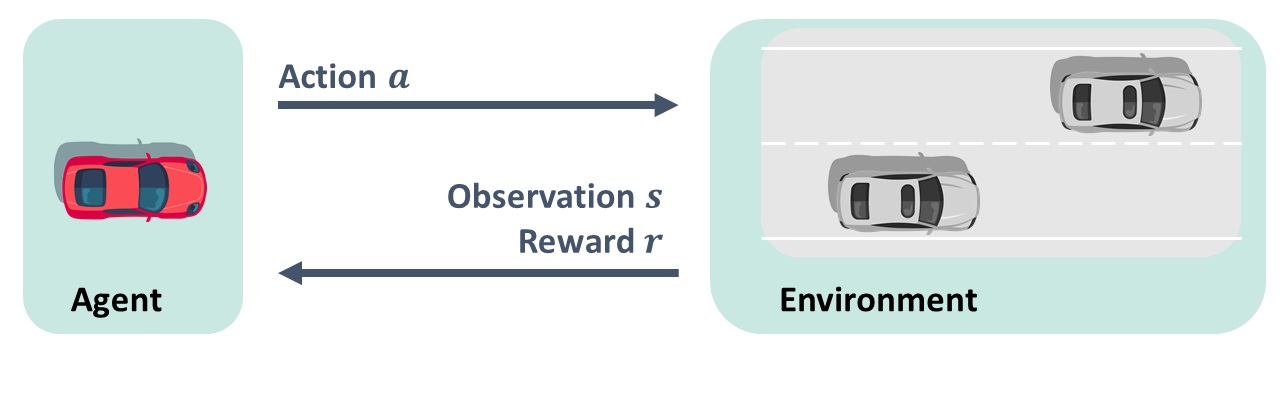

Hier haben wir mit SafeDQN einen klaren Ansatz implementiert, der aus seinen eigenen Fehlern lernt. Wir sehen hier wieder die Architektur des Reinforcement Learning Agenten für ein beschränktes Problem. Er bekommt den Zustand und die Belohnung und muss sich an Constraints halten. Für jeden Zustand muss gelernt werden, was die beste Aktion ist. Es werden zwei neuronale Netze trainiert, eines für den Nutzen der Aktionen, es optimiert das Fahren in Hinblick auf schnelles Erreichen des Zieles. Ein weiteres Netz wird für das Risiko der Aktionen trainiert, es lernt selbstständig aus Fehlern welche Verkehrssituationen riskant sind. Beide werden für alle möglichen Aktionen gemeinsam trainiert und es wird ein Kombinationsfaktor im Training bestimmt, der zur Auswahl der optimalen Aktion führt.

Wie man für eine spezifische Situation noch sicherer und nachvollziehbar werden kann, haben wir mit dem SafeVIPER-Ansatz gezeigt. Es gilt, mehrere Fahrzeuge, etwa auf der Autobahn, zu überholen. Nun ist hier das Auto vor einem unter Umständen schneller als das davor, und überholt vielleicht selbst. Es gilt, den optimalen Zeitpunkt für den Spurwechsel zu finden. Der SafeVIPER Algorithmus arbeitet in drei Schritten. Beim Training wird ein Reinforcement Learning Agent mit einem neuronalen Netz trainiert. Dabei wird im Safe Training ein beschränkter Markov-Prozess betrachtet, der den Agenten zu einem Sicherheitsabstand zwingt. Bei der Extraction wird mit Imitation Learning ein Entscheidungsbaum mit dem trainierten neuronalen Netz gelernt. Unsere Safe Extraction setzt dabei gleich drei Erweiterungen für die Sicherheit um. Bei der Verifikation nutzen wir nun aus, dass sich der Entscheidungsbaum ganz simpel in Aussagenlogik umwandeln lässt. Dazu formulieren wir die Dynamik der Umgebung und einen Unfall ebenfalls mit logischen Formeln. Lassen wir nun einen Gleichungslöser auf die zusammengefasste Formel Entscheidungsbaum und Umgebung führt zu Unfall los, und er findet keine erfüllende Belegung, haben wir nachgewiesen, dass unser Agent sicher ist.