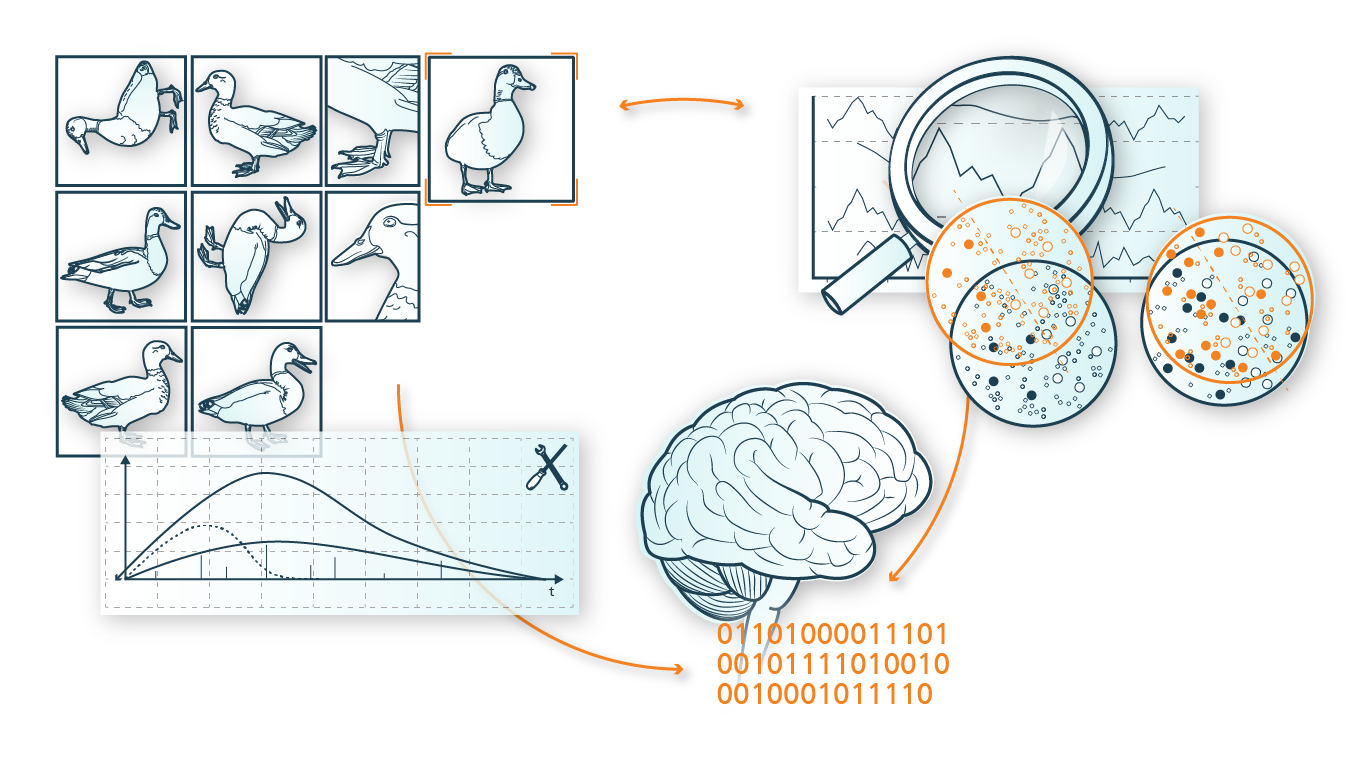

Bahnbrechende Anwendungen der Künstlichen Intelligenz (KI) in vielen Bereichen der Forschung und des Geschäftsalltags haben die letzten Jahre geprägt. Neben der Entwicklung neuer Algorithmen und der Zunahme von Rechenressourcen war der Hauptantrieb für diese Erfolge die Verfügbarkeit riesiger Mengen an annotierten Daten. Moderne KI-Algorithmen versuchen, Muster in statistischen Daten zu entdecken oder Modelle zu konstruieren, die in der Lage sind, den »richtigen« Output für einen vorhandenen Datensatz zu generieren.

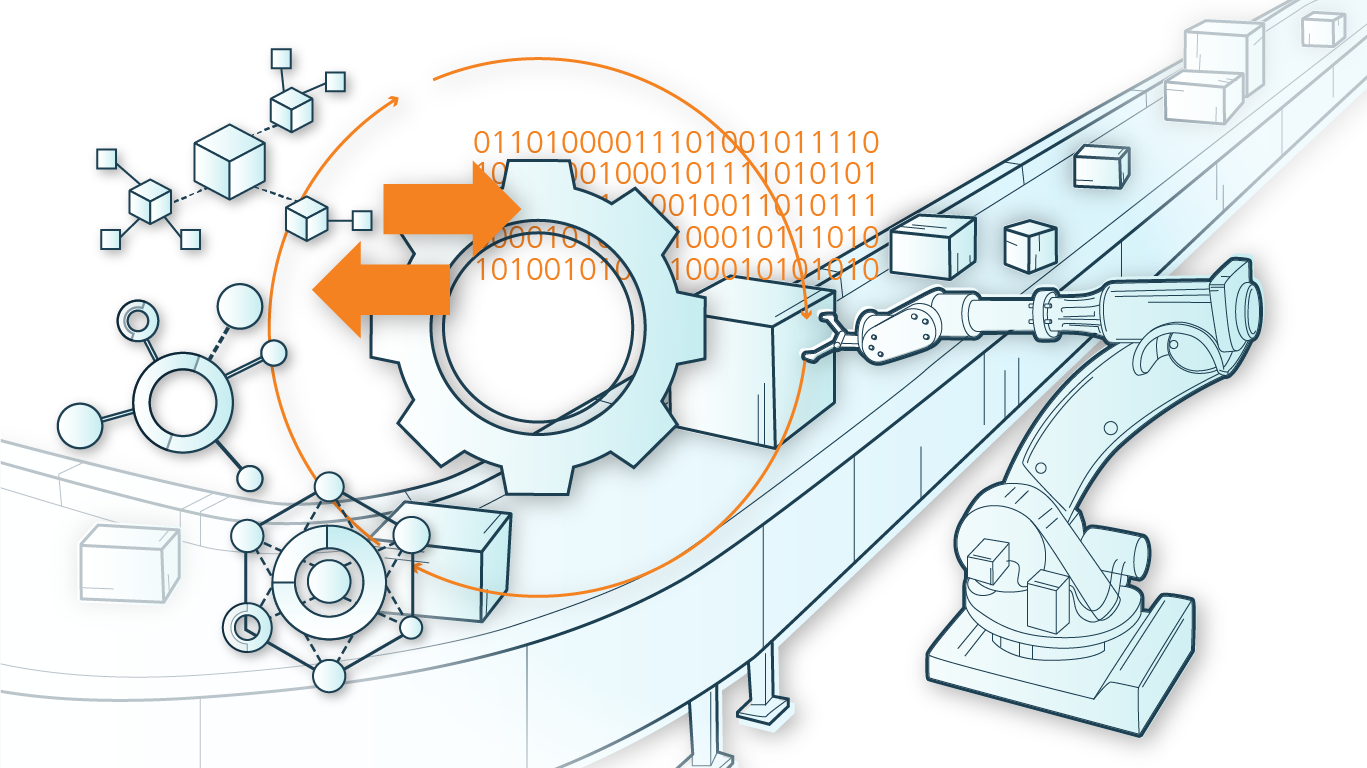

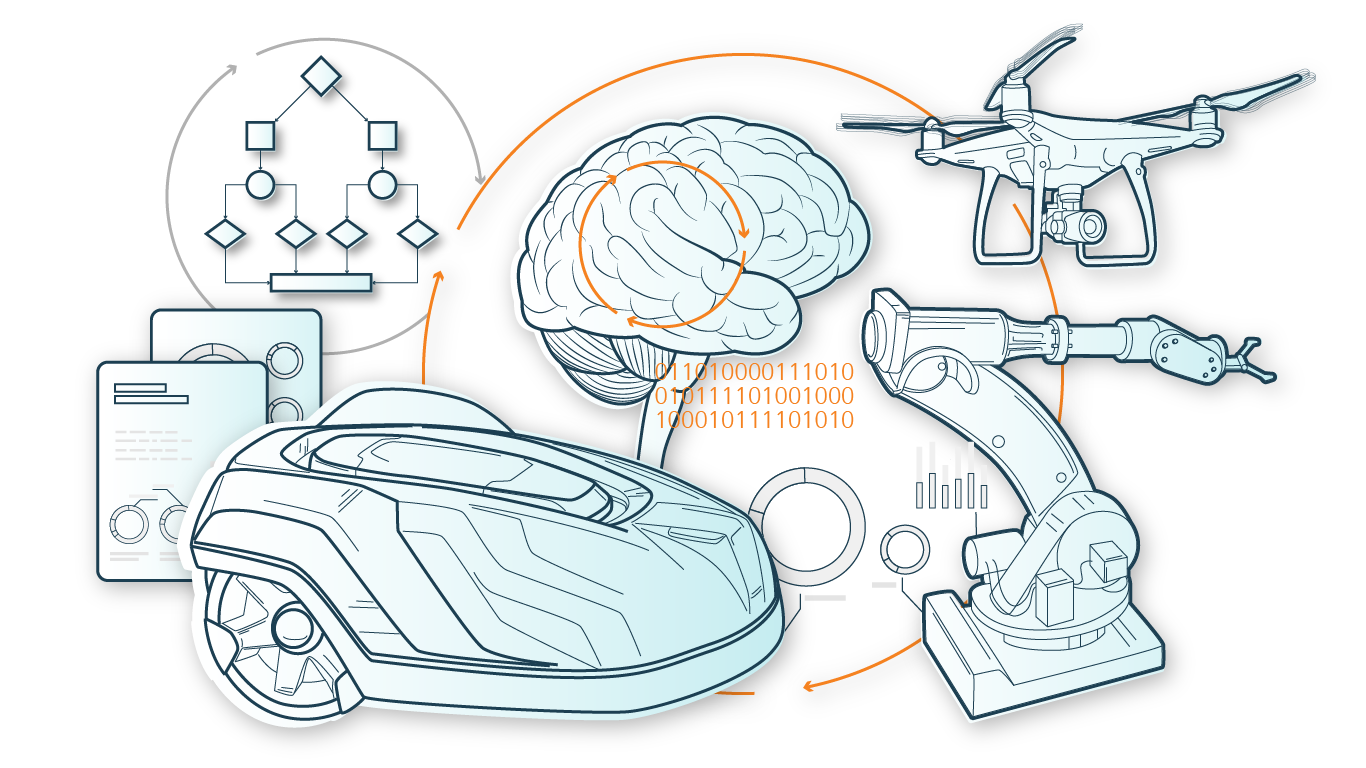

Um wirklich autonome Systeme zu entwickeln, die in der Lage sind, in der realen Welt zu operieren und mit dem Menschen zu interagieren, wie z. B. autonome Fahrzeuge, Paketlieferdrohnen oder sogar intelligente Produktionssysteme, sind andere Algorithmen als in bisherigen Paradigmen des maschinellen Lernens notwendig.

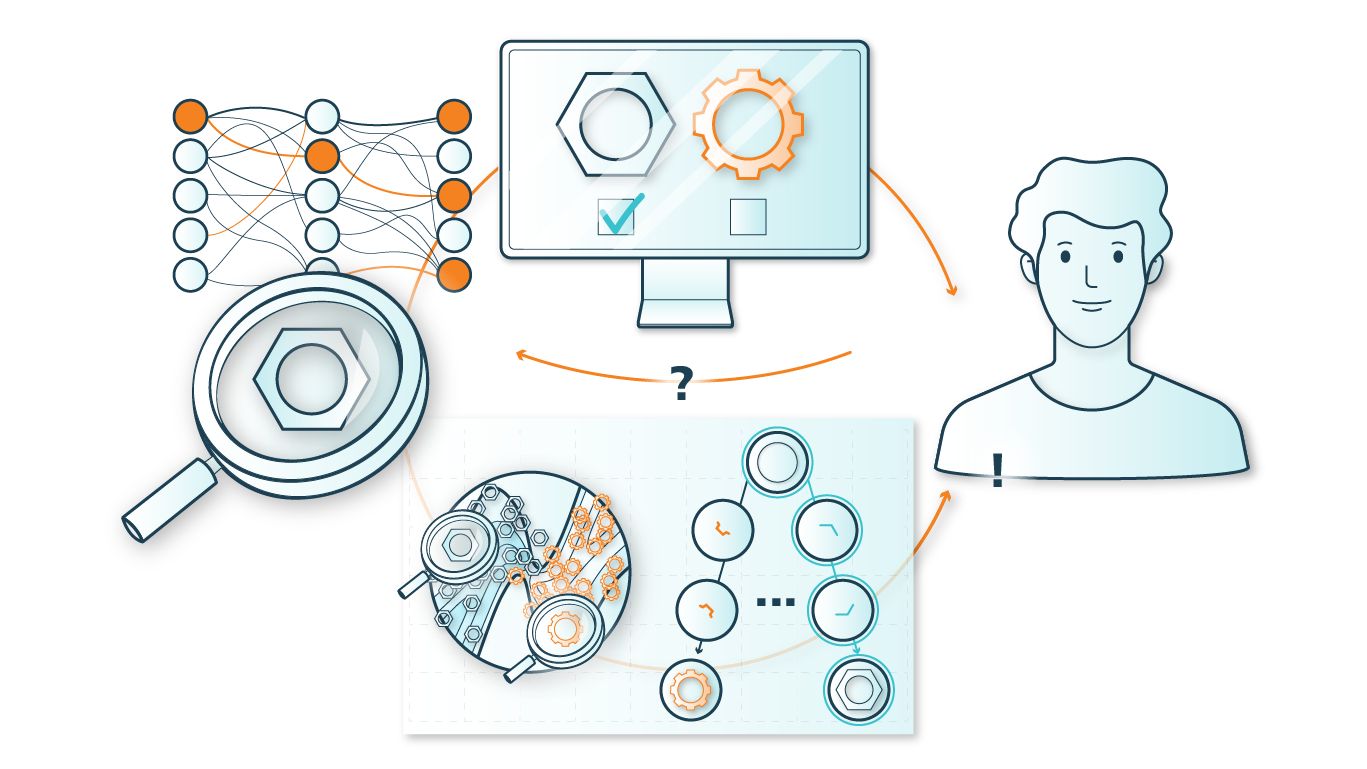

Die Anforderungen an die autonomen Systeme unterscheiden sich: sie müssen ohne Aufsicht operieren, eine Reihe von Entscheidungen treffen, um ein Ziel zu erreichen und in der Lage sein, sich an unvorhergesehene Situationen aufgrund der Komplexität der Welt anzupassen.

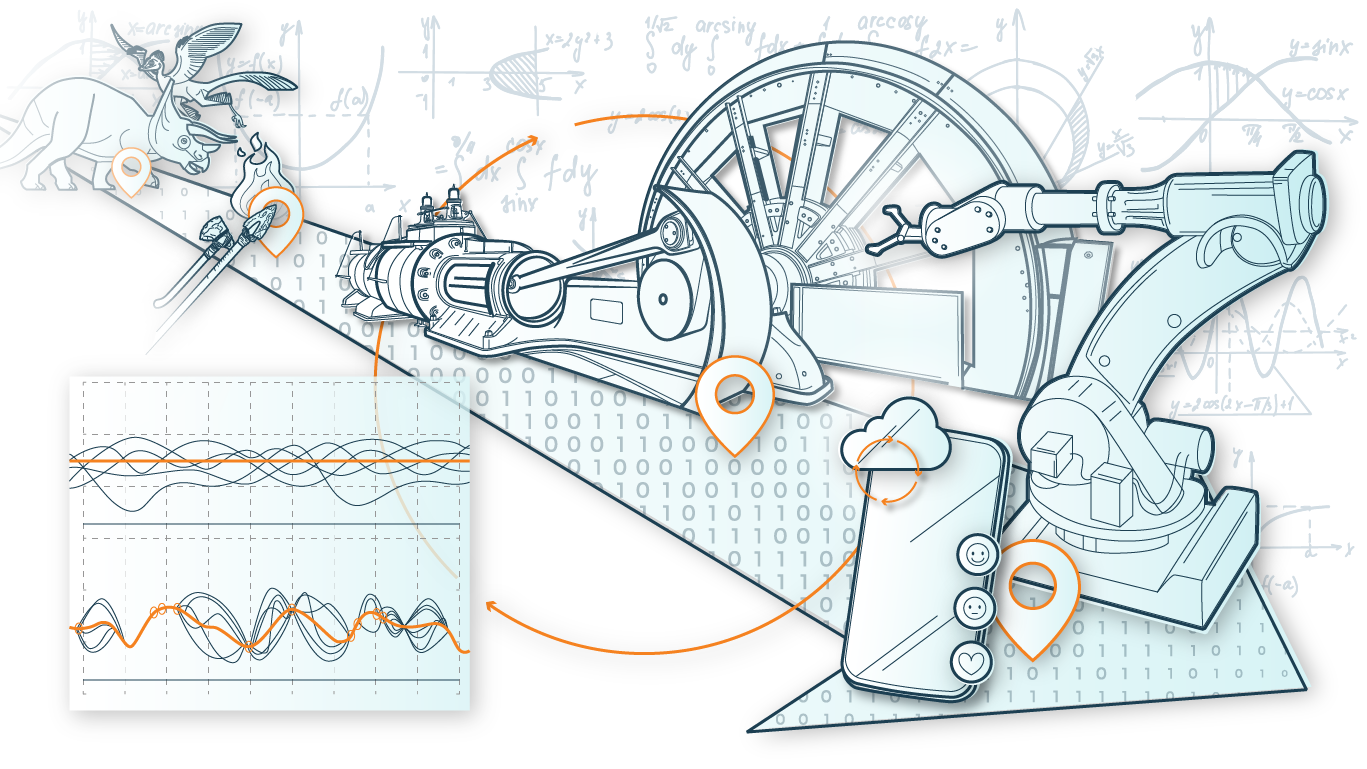

Erfahrungsbasiertes Lernen ist ein zentraler Baustein, um solche autonomen Systeme zu gestalten. Dabei wird das Verhalten des Systems nicht durch ein statisches Regelwerk oder statisches maschinelles Lernen vordefiniert. Es greift also nicht auf vorhandene annotierte oder auch nicht-annotierte Daten zurück, sondern sammelt diese Daten durch Interaktion mit der Umwelt selbst und verbessert sein Verhalten ständig weiter.

Das Teilgebiet des Reinforcement Learning ermöglicht das Training von Agenten, die durch die Interaktion mit der Umgebung in einem Trial-and-Error-Prozess eine Strategie (auch Controller oder Policy genannt) entdecken, die ihre Leistung verbessert, und liefert damit die theoretische Grundlage und ein großes Ökosystem von algorithmischen Ansätzen für das erfahrungsbasierte Training von autonomen Systemen.

Der Transfer von Ideen, Algorithmen und Erfolgsgeschichten der Reinforcement Learning Forschung in die industrielle Anwendung autonomer Systeme ist das Ziel der Arbeit in der Kompetenzsäule »Erfahrungsbasiertes Lernens«. Um dies zu erreichen, konzentrieren wir uns auf Ansätze, die zu verlässlichem Reinforcement Learning führen.