Das richtige Mischverhältnis finden mit Mathematischer Optimierung

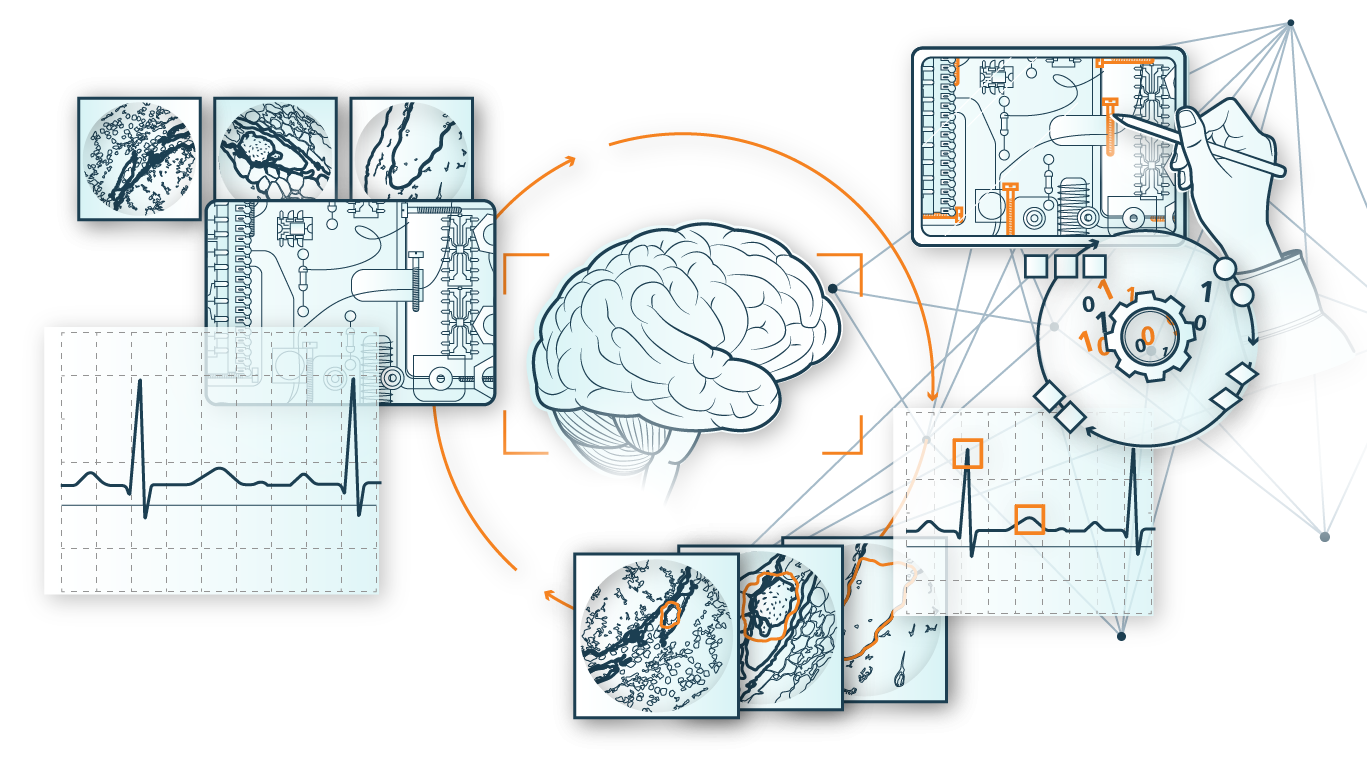

Mathematische Optimierungsmethoden sind für die Beschreibung und effiziente Planung komplexer Systeme unverzichtbar. Diese treten u.a. dort auf, wo bereits die schiere Anzahl der darin interagierenden Komponenten für eine Explosion in der Kombinatorik der zulässigen Lösungen sorgt. Gerade im Rahmen logistischer Entscheidungsprozesse spielt die Optimierung komplexer Systeme eine wesentliche Rolle. Man denke hierbei zum Beispiel an die Produktion in der Lebensmittelindustrie. Dort sind die Rohstoffe in gewissen, festgelegten Verhältnissen zu mischen, um die fertigen Produkte herzustellen. Die Anforderungen an die Inhaltstoffe sowie die gesetzlichen Vorgaben sind mittlerweile so komplex geworden, dass allein die Aufstellung einer zulässigen Zuordnung der Rohstoffchargen zu den Mischaufträgen bereits ein sehr schweres Problem darstellt; gar nicht zu reden vom Finden möglichst kostensparender Pläne. In der Applikation »selbstoptimierende adaptive logistische Netzwerke« entwickeln wir mathematische Modelle und Algorithmen zur Lösung solcher Problemstellungen.

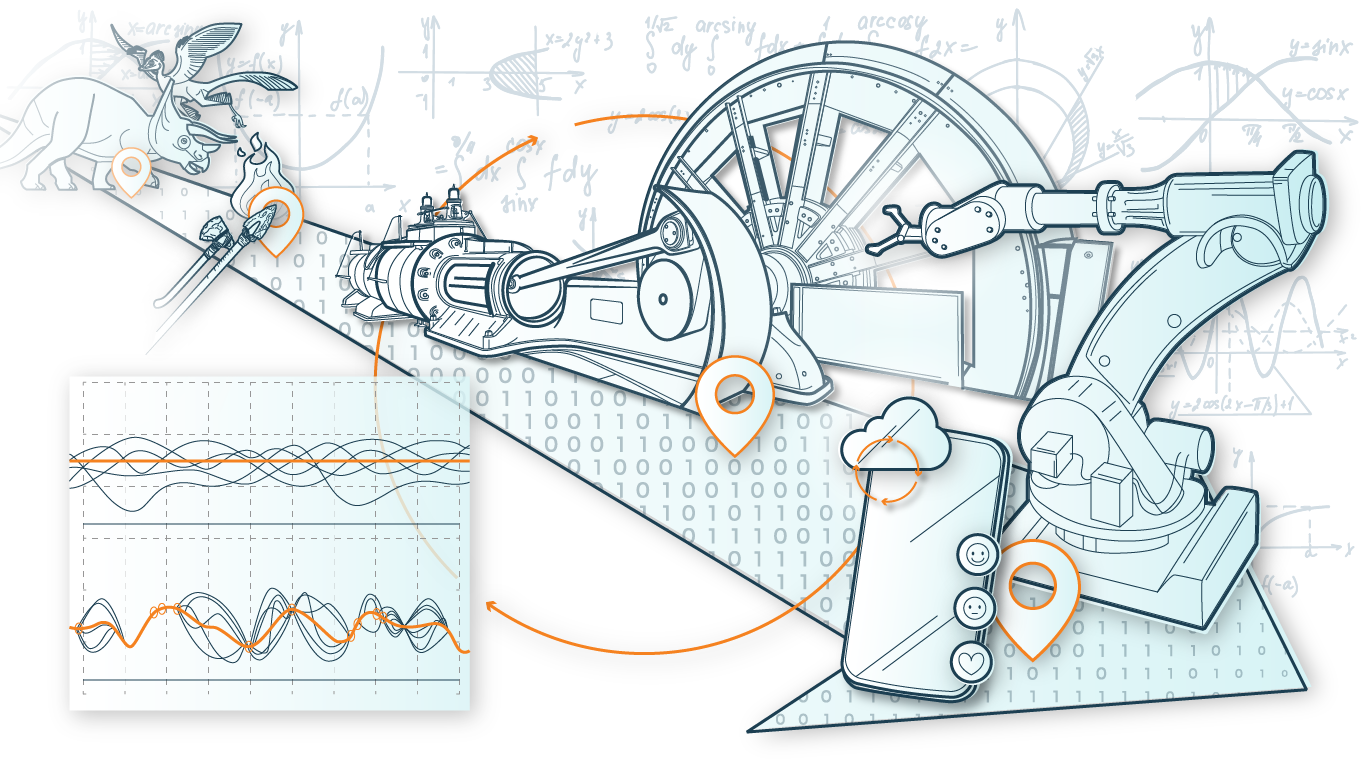

Fahrplanoptimierung zur Energieeinsparung im Schienenverkehr

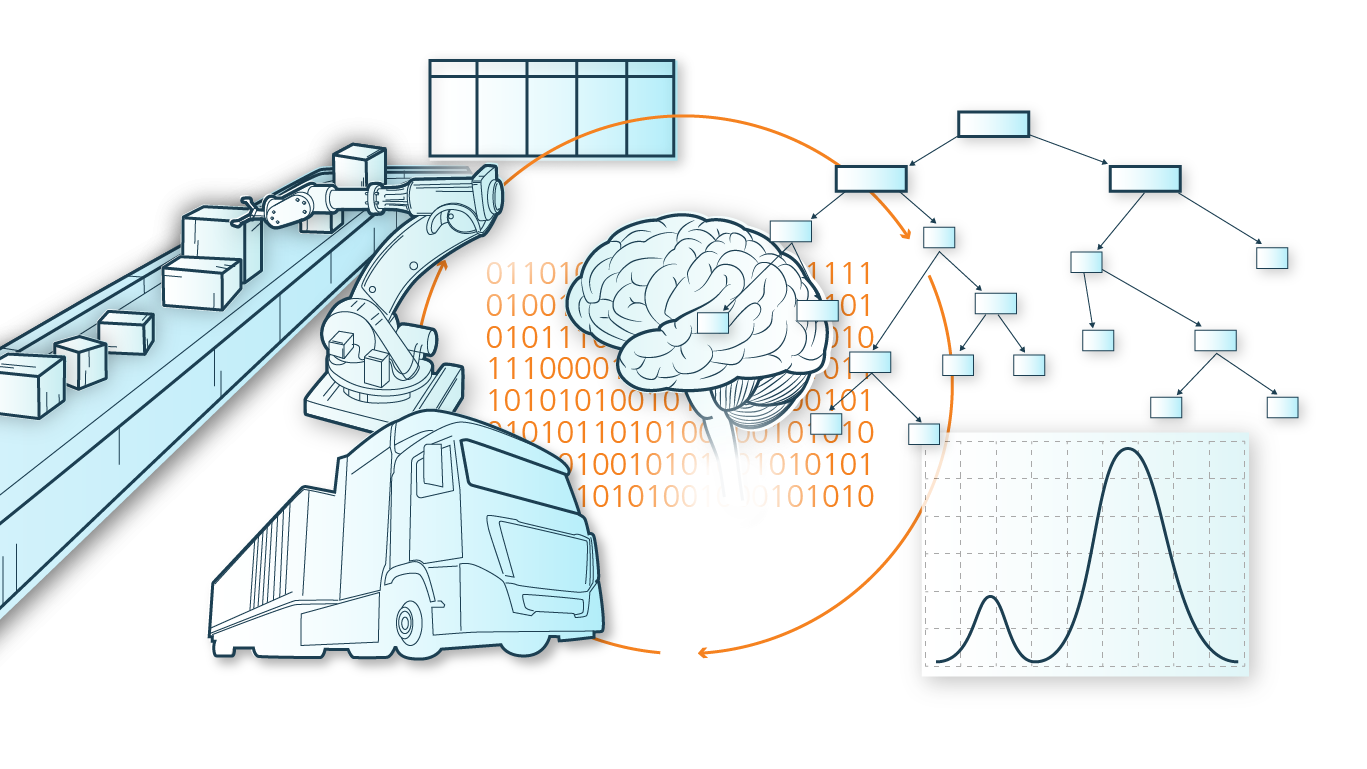

Im deutschen Schienennetz sind jeden Tag etwa 30.000 Züge unterwegs, die bei der Erstellung von Fahrplänen berücksichtigt werden müssen. In den letzten Jahren hat zusätzlich zu den üblichen Anforderungen an die Fahrplangestaltung, wie Pünktlichkeit und Betriebssicherheit, der Aspekt des Energieverbrauchs immer stärker an Bedeutung gewonnen. Will man im Rahmen der Fahrplanoptimierung auch den Energieverbrauch der Züge optimieren, inkl. ihrer Bewegungsdynamik, so entsteht ein Optimierungsproblem mit physikalischen Nebenbedingungen in Verbindung mit Schaltvorgängen. Die Mischung aus kontinuierlichem und diskretem Problemanteil führt dazu, dass man zur Lösung auf Verfahren der jeweils anderen Disziplin zurückgreifen kann. So sind oftmals Differenzialgleichungen zu linearisieren bevor diskrete Optimierungstechniken wieder zum Einsatz kommen können. Dies kann beispielsweise auf Basis von sog. stückweisen Linearisierungen erfolgen. Diese Technik erlaubt es, nichtlineare Funktionen in einem Optimierungsmodell durch Setzen von Stützstellen linear anzunähern. Solche und weitere Techniken werden im ADA Lovelace Center in der Applikation »Fahrerassistenzsysteme im Schienenverkehr« entwickelt und eingesetzt. In einem gemeinsamen Projekt mit der Verkehrs-Aktiengesellschaft VAG werden diese Techniken verwendet, um die Energieeffizienz des Nürnberger U-Bahn-Verkehrs zu erhöhen.

Optimale Netzauslegung in Gleichstromnetzen

Leistungselektronische Bausteine bilden den Kern unzähliger Anwendungen und Anlagen in Industrie, Energietechnik, Haustechnik und Mobilität. Verbaute Leistungswandler messen kontinuierlich Kenngrößen wie Strom, Spannung, und deren Änderung über die Zeit und ermitteln darüber indirekt den Zustand des verbundenen Gesamtsystems (beispielsweise des Energienetzes, einer Fertigungsanlage, eines Speichers oder Elektromotors). In der Applikation »Intelligente Leistungselektronik« entwickeln wir mathematische Modelle, um mit Hilfe dieser Daten die Stabilität von Gleichstromnetzen zu optimieren. Das Ziel ist dabei die Auswahl geeigneter Bauteile und die Justierung der Softwaresteuerung, um das Netz auf eine gewisse Bandbreite an Lastszenarien hin optimal auszurichten. Da die Simulation des Lastflusses in Gleichstromnetzen zu aufwändig ist, um sie direkt in ein Optimierungsmodell zu integrieren, trainieren wir Klassifikationsmodelle wie z. B. Entscheidungsbäume um die komplexen Einflüsse von Bauteilen und Software auf die Netzstabilität zu repräsentieren. Diese Randbedingungen werden gemischt-ganzzahlig reformuliert und stellen so die gelernten Zusammenhänge in deutlich einfacherer Form approximativ im Optimierungsmodell dar. Speziell darauf angepasste Dekompositionsalgorithmen sorgen für eine schnellere Berechnung der Lösung. Dadurch erhalten wir effiziente Verfahren zur Berechnung optimaler Netzauslegungen.