Vom Umgang mit verrauschten Daten in multivariaten Lernverfahren bis zur mehrstufigen Zeitreihenprognose

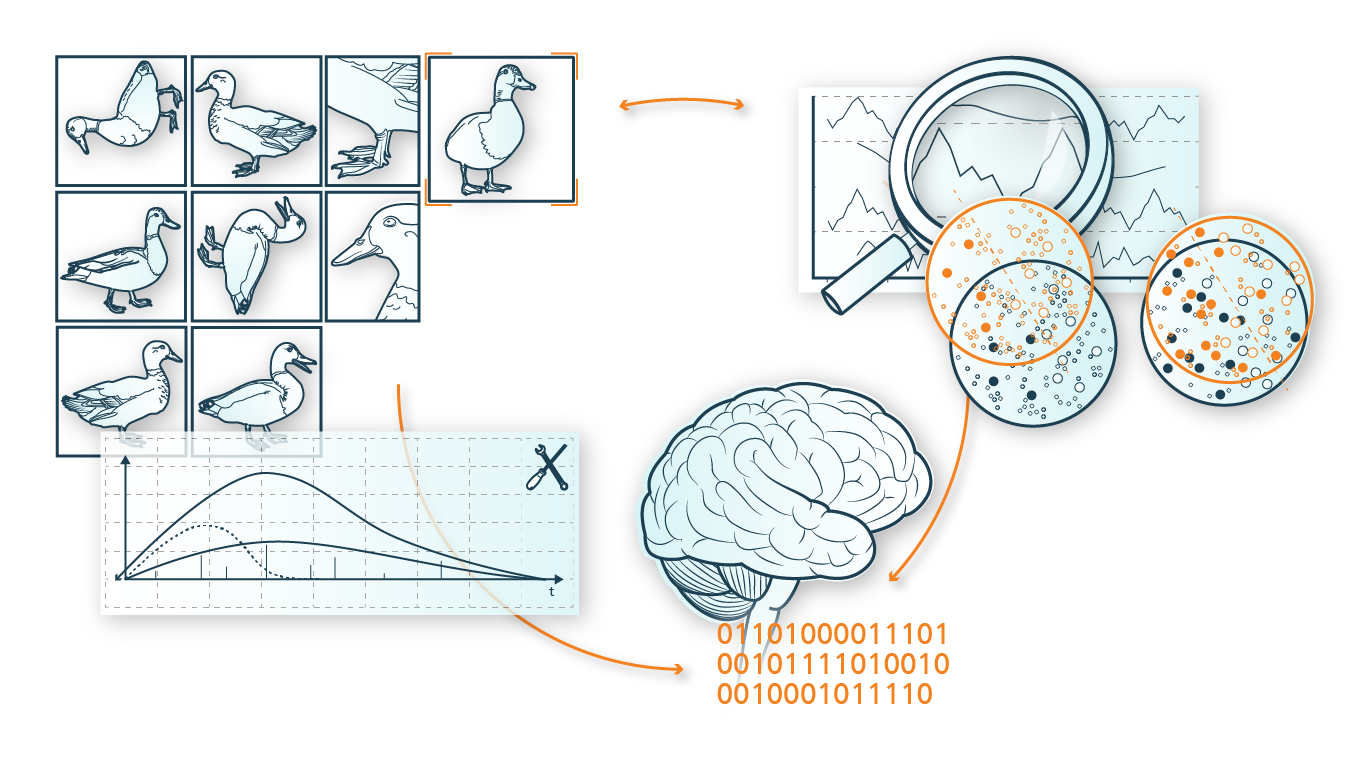

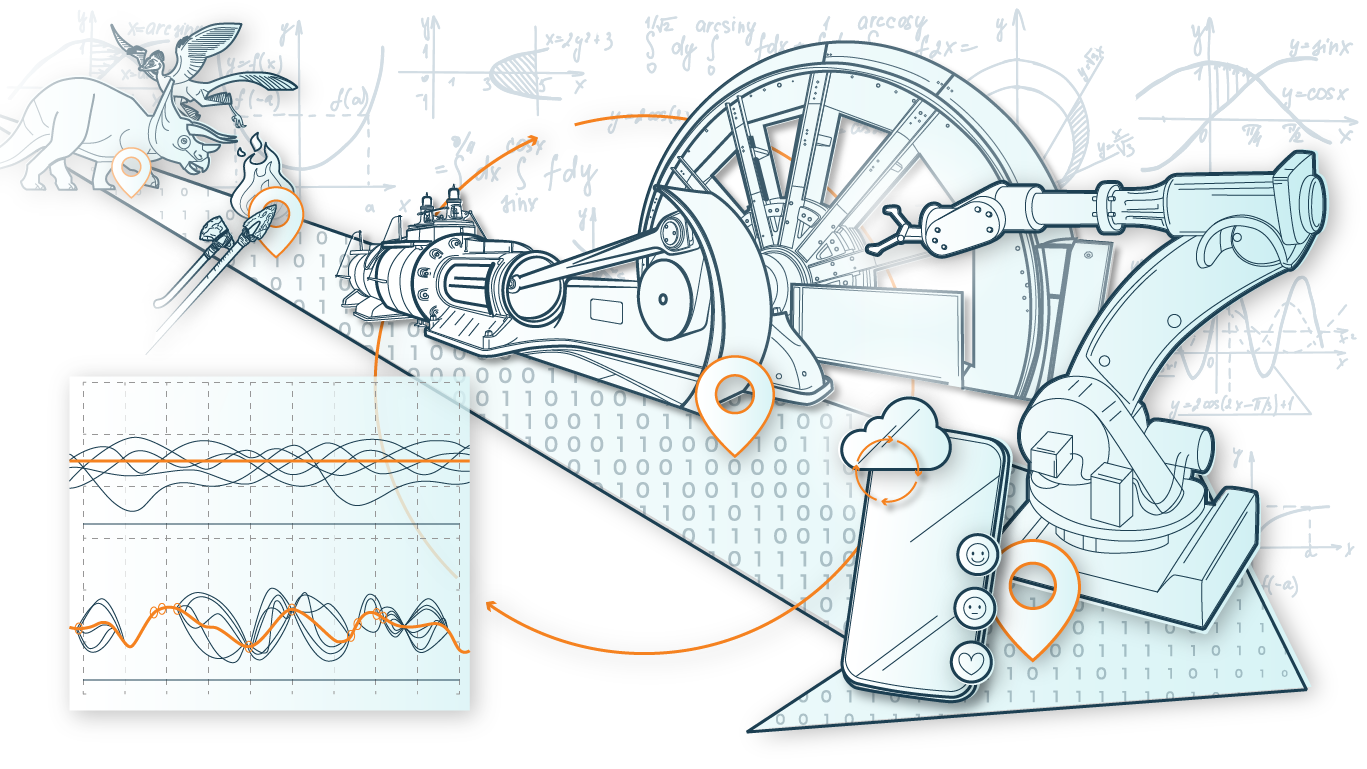

Die Forschung zur Analyse von Zeitreihen hat in den letzten Jahren an Dynamik gewonnen, da Erkenntnisse aus der Zeitreihenanalyse den Entscheidungsprozess für industrielle und wissenschaftliche Bereiche verbessern können. Zeitreihenanalyse zielt darauf ab, Muster und Entwicklungen zu beschreiben, die im Laufe der Zeit in Daten auftreten. Unter den vielen nützlichen Anwendungen von Zeitreihenanalyse sind die Klassifikation, Regression, Prognose und Anomaliedetektion von Zeitpunkten und Ereignissen in Sequenzen (Zeitreihen) besonders hervorzuheben, da sie wichtige Informationen beispielsweise zur Entscheidungsfindung von Unternehmen beitragen. In der heutigen informationsgetriebenen Welt werden an jedem Tag unzählige numerische Zeitreihen von Industrie und Forschung generiert. Für viele Anwendungen – unter anderem im Bereich Biologie, Medizin, Finanzen und Industrie – sind hochdimensionale Zeitreihen erforderlich. Der Umgang mit derart umfangreichen Datensätzen wirft verschiedene neue und interessante Herausforderungen auf.

Herausforderungen in natürlichen Prozessen

Trotz erheblicher Entwicklungen bei der multivariaten Analysemodellierung treten beim Umgang mit hochdimensionalen Daten immer noch Probleme auf, denn nicht alle Variablen haben direkten Einfluss auf die Zielvariable. So werden die Prognosen ungenau, wenn nicht verwandte Variablen berücksichtigt werden. Dies ist in praktischen Anwendungen wie der Signalverarbeitung häufig der Fall. Natürliche Prozesse, wie wir sie in den folgend genannten Applikationen finden, verarbeiten Daten, die durch einen multivariaten stochastischen Prozess beschrieben werden, um Beziehungen zu berücksichtigen, die zwischen den einzelnen Zeitreihen bestehen.