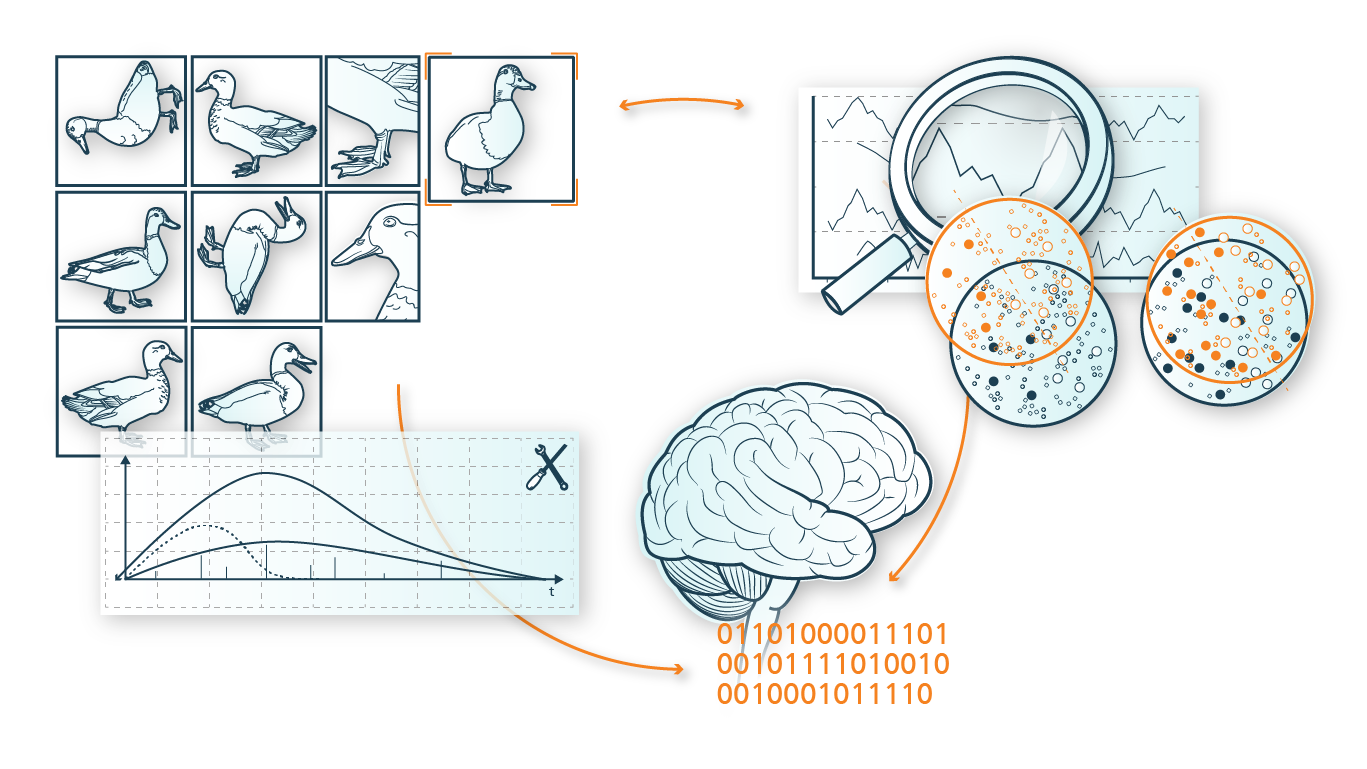

Die bahnbrechenden Erfolge von künstlicher Intelligenz (KI) bei Aufgaben wie Spracherkennung, Objekterkennung oder maschineller Übersetzung sind u.a. auf die Verfügbarkeit von enorm großen, annotierten Datensätzen zurückzuführen. Annotierte Daten, auch gelabelte Daten genannt, enthalten die Label-Informationen, die die Bedeutung einzelner Datenpunkte ausmachen und sind essentiell für das Training von Machine Learning Modellen. In vielen realen Szenarien, besonders im Industrieumfeld, liegen zwar oftmals große Datenmengen vor, diese sind aber nicht oder nur wenig annotiert. Dieses Fehlen annotierter Trainingsdaten stellt eine der großen Hürden für die breite Anwendung von KI-Methoden im Industrieumfeld dar. Daher wird in der Kompetenzsäule »Few Labels Learning« das Lernen mit wenig annotierten Daten innerhalb von drei Schwerpunkten und verschiedenen Bereichen erforscht: Meta-Lernstrategien, Semi-supervised Learning und Datensynthetisierung.